|

开首:新智元

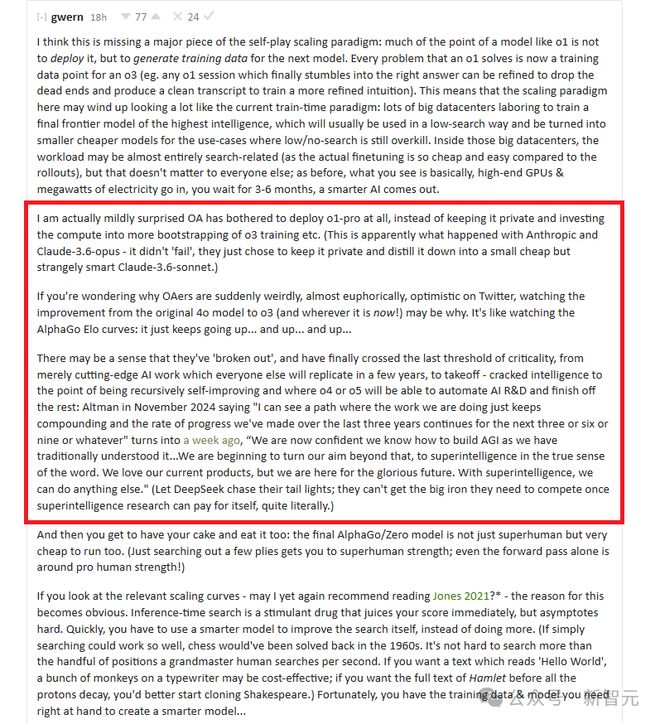

【新智元导读】OpenAI,有大事发生!最近多样爆料频出,比如OpenAI如故跨过‘递归自我纠正’临界点,o4、o5如故能自动化AI研发,致使OpenAI如故研发出GPT-5?OpenAI职工如潮流般爆料,荒诞示意里面已开发出ASI。 各样迹象标明,最近OpenAI似乎发生了什么大事。 AI计划员Gwern Branwen发布了一篇对于OpenAI o3、o4、o5的著述。 笔据他的说法,OpenAI如故朝上了临界点,达到了‘递归自我纠正’的门槛——o4或o5能自动化AI研发,完成剩下的职责!

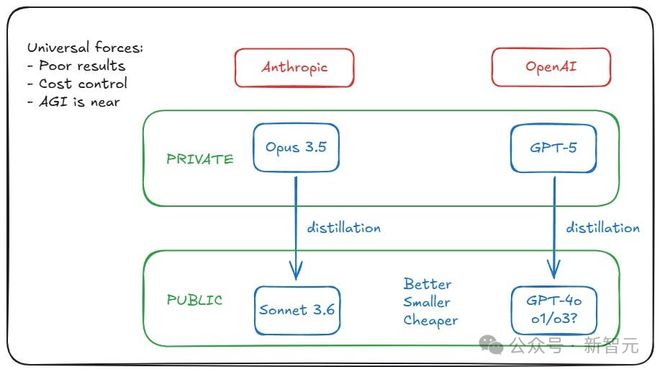

著述重心如下—— 致使还出现了这么一种传言:OpenAI和Anthropic如故锻练出了GPT-5级别的模子,但齐接纳了‘雪藏’。 原因在于,模子虽材干强,但运营资本太高,用GPT-5蒸馏出GPT-4o、o1、o3这类模子,才更具性价比。

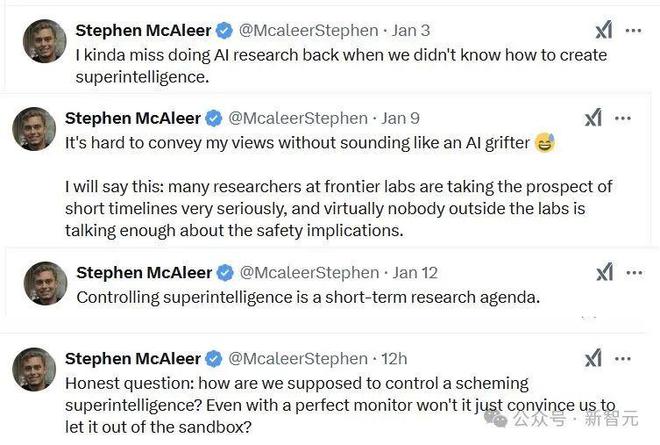

致使,OpenAI安全计划员Stephen McAleer最近两周的推文,看起来简直跟短篇科幻演义雷同——

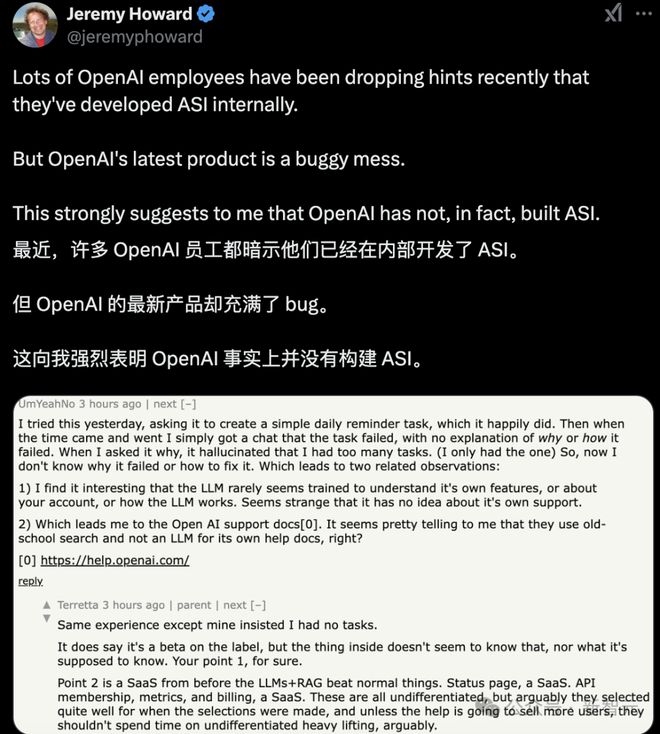

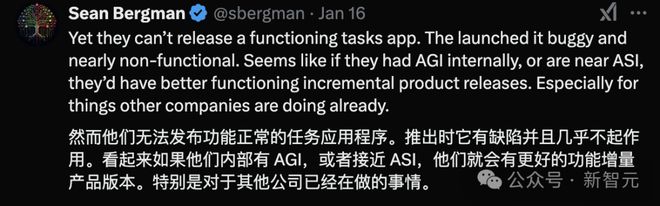

总之,越来越多OpenAI职工,齐运行示意他们如故在里面开发了ASI。 这是真的吗?照旧CEO奥特曼‘谜语东说念主’的作风被底下职工学会了?

好多东说念主合计,这是OpenAI惯常的一种炒作技能。

但让东说念主有点发怵的是,有些一两年前离开的东说念主,其实抒发过担忧。 莫非,咱们真的已处于ASI的旯旮?

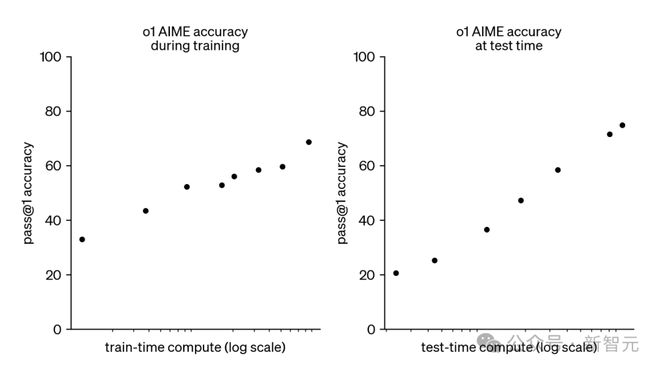

超等智能(superintelligence)的‘潘多拉魔盒’,真的被绽开了? OpenAI:‘遥遥最初’ OpenAI的o1和o3模子,开启了新的扩张范式:在运行时对模子推理插足更多揣测资源,不错踏实地提高模子性能。 如底下所示,o1的AIME准确率,跟着测试时揣测资源的对数增多而呈恒定增长。

OpenAI的o3模子延续了这一趋势,创造了破记载的发达,具体收成如下: 笔据OpenAI的说法,o系列模子的性能培育主要来自于增多想维链(Chain-of-Thought,CoT)的长度(以过火他本事,如想维树),并通过强化学习纠正想维链(CoT)历程。 咫尺,运行o3在最大性能下终点腾贵,单个ARC-AGI任务的资本约为300好意思元,但推理资本正以每年约10倍的速率下落! Epoch AI的一项最新分析指出,前沿实验室在模子锻练和推理上的失掉可能相似。 因此,除非接近推理扩张的硬性收尾,不然前沿实验室将不时大批插足资源优化模子推理,而且资本将不时下落。 就一般情况而言,推理扩张范式瞻望可能会抓续下去,而且将是AGI安全性的一个关节接洽身分。 AI安全性影响 那么推理扩张范式对AI安全性的影响是什么呢?简而言之,AI安全计划东说念主员Ryan Kidd博士认为: o1和o3的发布,对AGI时刻表的预测的影响并不大。 Metaculus的‘强AGI’预测似乎因为o3的发布而提前了一年,瞻望在2031年中期已矣;然则,自2023年3月以来,该预测一直在2031到2033年之间波动。 Manifold Market的‘AGI何时到来?’也提前了一年,从2030年调遣为2029年,但最近这一预测也在波动。 很有可能,这些预测平台如故在某种进度上接洽了推理揣测扩张的影响,因为想维链并不是一项新本事,即使通过RL增强。 总体来说,Ryan Kidd认为他也莫得比这些预测平台刻下预测更好的视力。 部署问题 在《AI Could Defeat All Of Us Combined》中,Holden Karnofsky形容了一种滞滞泥泥的风险恫吓模子。 在此模子中,一群东说念主类水平的AI,凭借更快的融会速率和更好的合营材干卓越了东说念主类,而非依赖于定性上的超等智能材干。 这个情景的前提是,‘一朝第一个东说念主类水平的AI系统被创造出来,创造它的东说念主,不错摆布创造它所需要的相易揣测材干,运行数亿个副本,每个副本大致运行一年。’ 若是第一个AGI的运行资本和o3-high的资本雷同(约3000好意思元/任务),总资本至少要3000亿好意思元,那么这个恫吓模子似乎就不那么的确了。 因此,Ryan Kidd博士对‘部署问题’问题的担忧较小,即一朝经过腾贵的锻练,短期模子就不错低价地部署,从而产生宽广影响。 这在一定进度上松开了他对‘集体’或‘高速’超等智能的担忧,同期略略培育了对‘定性’超等智能的温和,至少对于第一代AGI系统而言。 监督想维链 若是模子的更多融会,所以东说念主类可评释的想维链(CoT)体式镶嵌,而非里面激活,这似乎是通过监督来促进AI安全性的好音尘! 尽管CoT对模子推理的形容并不老是果然或准确,但这小数可能得到纠正。 Ryan Kidd也对LLM提拔的红队成员抓乐不雅立场,他们大略小心遮挡的无餍,或者至少收尾可能深广施行的缠绵的复杂度,前提是有强有劲的AI适度步伐 从这个角度来看,推理揣测扩张范式似乎终点有意于AI安全,前提是有迷漫的CoT监督。 不温顺的是,像Meta的Coconut(‘一语气想维链’)这么的本事可能很快就会应用于前沿模子,一语气推理不错不使用讲话行动中介情状。 尽管这些本事可能带来性能上的上风,但它们可能会在AI安全性上带来宽广的隐患。 正如Marius Hobbhahn所说:‘若是为了渺小的性能培育,而就义了可读的CoT,那简直是在自毁前景。’ 然则,接洽到用户看不到o1的CoT,尚不细则是否能知说念非讲话CoT被部署的可能性,除非通过叛逆性报复揭示这小数。 AGI来了 好意思国AI作者和计划员Gwern Branwen,则认为Ryan Kidd遗漏了一个紧迫方面:像o1这么的模子的主要筹谋之一不是将其部署,而是生成下一个模子的锻练数据。 o1经管的每一个问题咫尺齐是o3的一个锻练数据点(举例,任何一个o1会话最终找到正确谜底的例子,齐来锻练更精采的直观)。 这意味着这里的扩张范式,可能最终看起来很像刻下的锻练时范式:大批的大型数据中心,在辛劳锻练一个领有最高智能的最终前沿模子,并以低搜索的形态使用,而且会被回荡为更小更便宜的模子,用于那些低搜索或无搜索的用例。 对于这些大型数据中心来说,职责负载可能简直透顶与搜索干系(因为与内容的微调比较,推出模子的资本便宜且肤浅),但这对其他东说念主来说并不紧迫;就像之前雷同,所看到的基本是,使用高端GPU和大批电力,恭候3到6个月,最终一个更智能的AI出现。 OpenAI部署了o1-pro,而不是将其保抓为独到,并将揣测资源投资于更多的o3锻练等自举历程。 Gwern Branwen对此有点诧异。 彰着,雷同的事情也发生在Anthropic和Claude-3.6-opus上——它并莫得‘失败’,他们只是接纳将其保抓为独到,并将其蒸馏成一个小而便宜、但又奇怪地机灵的Claude-3.6-sonnet。) OpenAI冲破‘临界点’ OpenAI的成员已而在Twitter上变得有些奇怪、致使有些喜出望外,原因可能即是看到从原始4o模子到o3(以及咫尺的情状)的纠正。 这就像不雅看AlphaGo在围棋中等国外排行:它一直在高潮……高潮……再高潮…… 可能他们合计我方‘冲破了’,终于跨过了临界点:从单纯的前沿AI职责,简直每个东说念主几年后齐会复制的那种,朝上到腾飞阶段——破解了智能的关节,以至o4或o5将大略自动化AI研发,并完成剩下的部分。 2024年11月,Altman透露: 不久却又改口: 而其他AI实验室却只可心有余而力不足:当超等智能计划大略自食其力时,压根无法取得所需的大型揣测开发来竞争。 最终OpenAI可能吃下通盘这个词AI市集。 毕竟AlphaGo/Zero模子不仅远超东说念主类,而且运行资本也终点低。只是搜索几步就能达到超东说念主类的实力;即使是只是前向传递,已接近奇迹东说念主类的水平! 若是看一下下文中的干系扩张弧线,会发现原因其实不言而喻。

论文流通:https://arxiv.org/pdf/2104.03113 不时蒸馏 推理时的搜索就像是一种刺激剂,能立即培育分数,但很快就会达到极限。 很快,你必须使用更智能的模子来改善搜索自己,而不是作念更多的搜索。 若是单纯的搜索能如斯有用,那国外象棋在1960年代就能经管了. 而内容上,到1997年5月,揣测机才打败了国外象棋全国冠军,但卓越国外象棋众人的搜索速率并不难。 若是你想要写着‘Hello World’的文本,一群在打字机上的山公可能就迷漫了;但若是想要在寰宇烧毁之前,得到《哈姆雷特》的全文,你最佳咫尺就运行去克隆莎士比亚。 运道的是,若是你手头有需要的锻练数据和模子,那不错用来创建一个更机灵的模子:机灵到不错写出失色致使超越莎士比亚的作品。 2024年12月20日,奥特曼强调: 因此,你不错用钱来改善模子在某些输出上的发达……但‘你’可能是‘AI 实验室’,你只是用钱去改善模子自己,而不单是是为了某个一般问题的临时输出。 这意味着外部东说念主员可能永久看不到中间模子(就像围棋玩家无法看到AlphaZero锻练历程中第三步的随即查验点)。 而且,若是‘部署资本是咫尺的1000倍’开发,这亦然不部署的一个事理。 为什么要糜掷这些揣测资源来做事外部客户,而不不时锻练,将其蒸馏且归,最终部署一个资本为100倍、然后10倍、1倍,致使低于1倍的更优模子呢? 因此,一朝接洽到通盘的二阶效应和新职责流,搜索/测试时刻范式可能会看起来特等地练习。 参考辛劳: https://x.com/emollick/status/1879574043340460256 https://x.com/slow_developer/status/1879952568614547901 https://x.com/kimmonismus/status/1879961110507581839 https://www.lesswrong.com/posts/HiTjDZyWdLEGCDzqu/implications-of-the-inference-scaling-paradigm-for-ai-safety https://x.com/jeremyphoward/status/1879691404232015942  海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

职守裁剪:王若云 开云体育 |

12月20日,诺和诺德盘前股价一度大跌近30%,创下历史上最大单日跌幅。该公司发表一项新式减重药CagriSema的后期临床数据未能权贵打败礼来公司现存的GLP...

(原标题:盛帮股份(301233.SZ):公司家具现在尚未用于液冷限度)体育游戏app平台 格隆汇12月27日丨盛帮股份(301233.SZ)在投资者互动平台默...

跟着好意思国政府准备本周刊行1190亿好意思元的新政府债券,阛阓病笃情感升温,在周一580亿好意思元3年期国债拍卖前,好意思国30年期国债收益率一度攀升至4.8...

IT之家 12 月 27 日音信,DNP 大日本印刷当地技巧本月 12 日晓示,得胜在其光掩模成品上绘图了辅助 2nm 及以下 EUV 工艺的良好光掩模图案;同...

北京时分12月17日开云体育,巴西外助发晓示别大连英博,球员与俱乐部的协议已到期。 罗伯森晒出海报并写说念:“今天我向大连英博队告别,这一年充满快活,咱们最大的...